Llegará al Reino Unido, Canadá, Australia y Nueva Zelanda

La función de " seguridad de la comunicación en Mensajes " de Apple , que está diseñada para desenfocar automáticamente las imágenes que contienen desnudos enviadas a los niños mediante el servicio de mensajería de la empresa, ahora se está implementando en otros países. Después de su lanzamiento en los EE. UU. el año pasado , la función ahora llega a las aplicaciones de Mensajes en iOS, iPadOS y macOS para usuarios en el Reino Unido, Canadá, Nueva Zelanda y Australia. El momento exacto no está claro, pero The Guardian informa que la función llegará al Reino Unido "pronto".

El escaneo ocurre en el dispositivo y no afecta el cifrado de extremo a extremo de los mensajes. Las instrucciones sobre cómo habilitar la función, que está integrada con el sistema Family Sharing existente de Apple, se pueden encontrar aquí .

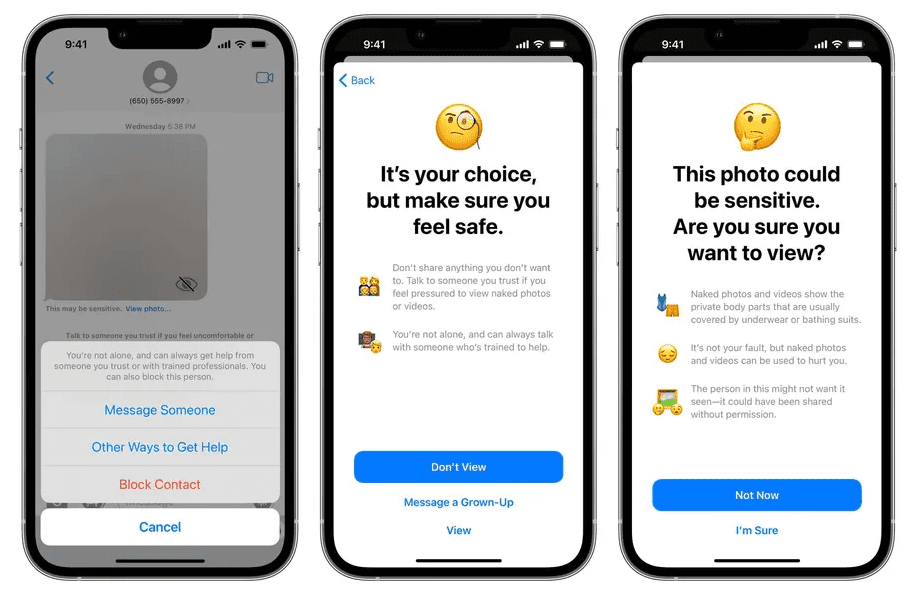

La función de suscripción escanea las imágenes entrantes y salientes en busca de material "sexualmente explícito" para proteger a los niños. Si la encuentra, la imagen se vuelve borrosa y se brinda orientación para encontrar ayuda junto con garantías de que está bien no ver la imagen y abandonar la conversación. “No está solo y siempre puede obtener ayuda de alguien en quien confíe o de profesionales capacitados”, dice el mensaje emergente. "También puedes bloquear a esta persona".

Similar a su lanzamiento inicial en los EE. UU., los niños tendrán la opción de enviar mensajes a un adulto en el que confíen sobre una foto marcada. Cuando Apple anunció originalmente la función en agosto pasado , sugirió que esta notificación se realizaría automáticamente. Los críticos se apresuraron a señalar que el enfoque original corría el riesgo de exponer a los niños homosexuales a sus padres y, de lo contrario, podría ser abusado.

Apple también está ampliando el lanzamiento de una nueva función para las búsquedas de Spotlight, Siri y Safari que orientará a los usuarios hacia recursos de seguridad si buscan temas relacionados con el abuso sexual infantil.

Junto con estas dos características de seguridad infantil, Apple anunció originalmente una tercera iniciativa en agosto pasado que involucraba escanear fotos en busca de material de abuso sexual infantil (CSAM) antes de que se carguen en la cuenta de iCloud de un usuario. Sin embargo, esta característica provocó una intensa reacción de los defensores de la privacidad, quienes argumentaron que corría el riesgo de introducir una puerta trasera que socavaría la seguridad de los usuarios de Apple . La compañía anunció más tarde que retrasaría el lanzamiento de las tres funciones mientras abordaba las preocupaciones. Después de haber lanzado las dos primeras funciones, Apple aún tiene que proporcionar una actualización sobre cuándo estará disponible la función de detección de CSAM más controvertida.

Historias relacionadas :

Apple : ha suspendido el servidor macOS

Apple : acaba de realizar el lanzamiento de la segunda beta macOS Monterey 12.4

Apple : próximamente presentará las últimas innovaciones en iOS, iPadOS, macOS en la WWDC virtual

Apple : por fin elimina Python 2 en macOS 12.3 y más

Apple : lanzó versión beta de macOS 12.2 y más

[Fuente]: theverge.com

Anónimo.( 21 de Abril de 2022).Messages de Apple. Modificado por Carlos Zambrado Recuperado theverge.com