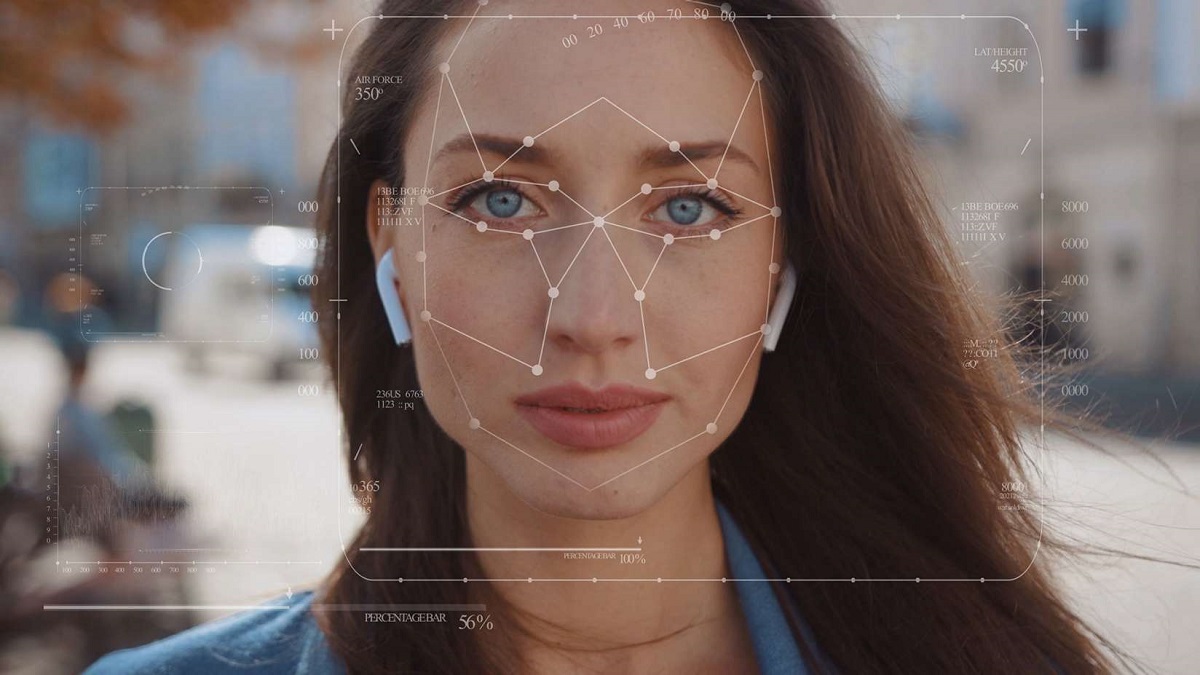

Los deepfakes son uno de los desarrollos más preocupantes en materia de IA. Suelen ser vídeos terriblemente realistas de personas que dicen y hacen cosas que nunca han hecho. En general, se crean superponiendo una cara, normalmente la de un famoso, sobre la de otra persona para hacer estos vídeos engañosos.

Los deepfakes son uno de los desarrollos más preocupantes en materia de IA. Suelen ser vídeos terriblemente realistas de personas que dicen y hacen cosas que nunca han hecho. En general, se crean superponiendo una cara, normalmente la de un famoso, sobre la de otra persona para hacer estos vídeos engañosos.

¿Qué es DeepFakes?

El nombre de deepfake viene de Deep Learning, traducido como aprendizaje profundo, una de las corrientes de la Inteligencia Artificial. En este caso, es el aprendizaje con inteligencia artificial que se utiliza con la intención de crear contenido falso.

| Puede leer también | Facebook sancionará a políticos que publiquen "fake news"

En la mayoría de los casos, esto se basa en manipulaciones de video en las que el software analiza el material de origen y extrae parte de él, luego lo inserta y lo adapta en otro video. Los llamados intercambios de caras o deep video portraits son la forma más común de los fake.

Los Videos DeepFakes

A menudo pretenden ser divertidos, o al menos no están hechos con ninguna intención seria. Algunos buscan crear películas con actores famosos sin tener que salir de casa. Pero, como puedes imaginar, hay una tonelada de porno que utiliza deepfakes, que van desde fantasías hechas con personajes de videojuegos hasta imágenes problemáticas de personas reales.

| Puede leer también | ¿Cuál es la diferencia Deep Learning frente a Machine Learning?

Aparte de la flagrante falta de respeto que esto puede suponer para las imágenes de personas utilizadas, una de las cosas más peligrosas de los deepfakes es que son realmente buenos. Con los deepfakes que nunca habría adivinado que no eran reales, y eso es especialmente peligroso cuando tenemos un Internet que puede difundir la desinformación como un reguero de pólvora.

"Los vídeos deepfake están por todas partes. Probablemente ya los hayas visto: vídeos de famosos haciendo o diciendo cosas que nunca hicieron en realidad", explica Ilke Demir, científico investigador senior de los laboratorios Intel.

La tecnología FakeCatCher de Intel

Resulta que se necesita una IA para atrapar a una IA y, afortunadamente, Intel ha estado trabajando precisamente en eso. La compañía ha estado trabajando en esfuerzos como parte de su trabajo de IA responsable, y ha desarrollado lo que Intel ha denominado FakeCatcher. Se trata de una tecnología diseñada específicamente para detectar vídeos falsos, como los deepfakes, y al parecer puede hacerlo en milisegundos con una tasa de precisión del 96%.

| Puede leer también | En 2033, el Tesla de Elon Musk y su IA serán más inteligentes que los humanos

Intel explica que muchas otras herramientas que intentan detectar deepfakes tratan de analizar los datos en bruto de los archivos, mientras que FakeCatcher ha sido entrenado con técnicas de aprendizaje profundo para detectar el aspecto de un humano real en los vídeos. Esto significa que ha sido entrenado para buscar todas las pequeñas cosas que hacen que las personas sean reales. Cosas sutiles como notar el flujo de sangre en los píxeles de un vídeo, que aparentemente los deepfakes aún no dominan. Aunque tal vez sea así como aprendan a dominar los efectos de la sangre humana. Esa es una frase espeluznante si alguna vez he escrito una.

Basada en la web

FakeCatcher está trabajando en una plataforma basada en la web que, con suerte, permitirá a cualquiera tener acceso a la tecnología. En el back-end utiliza procesadores escalables Xeon de tercera generación de Intel combinados con un montón de software propio para realizar los cálculos necesarios.

Si quieres saber más sobre el FakeCatcher de Intel, echa un vistazo al vídeo al Video de Intel.

Créditos Imagen: Intel