Es probable que hayas oído que Google ha emitido recientemente el Código Rojo por temor a que la creciente popularidad de ChatGPT -que se ejecuta en la arquitectura GPT-3.5- amenace potencialmente el negocio publicitario de la búsqueda de Google. Además, el inminente ruido de que GPT-4 está a la vuelta de la esquina tiene a la gente zumbando sobre lo que nos espera el año que viene. Sin embargo, a pesar de los murmullos, Google sigue liderando la carrera de la IA con su Pathways Language Model (PaLM), lanzado a principios de este año.

Es probable que hayas oído que Google ha emitido recientemente el Código Rojo por temor a que la creciente popularidad de ChatGPT -que se ejecuta en la arquitectura GPT-3.5- amenace potencialmente el negocio publicitario de la búsqueda de Google. Además, el inminente ruido de que GPT-4 está a la vuelta de la esquina tiene a la gente zumbando sobre lo que nos espera el año que viene. Sin embargo, a pesar de los murmullos, Google sigue liderando la carrera de la IA con su Pathways Language Model (PaLM), lanzado a principios de este año.

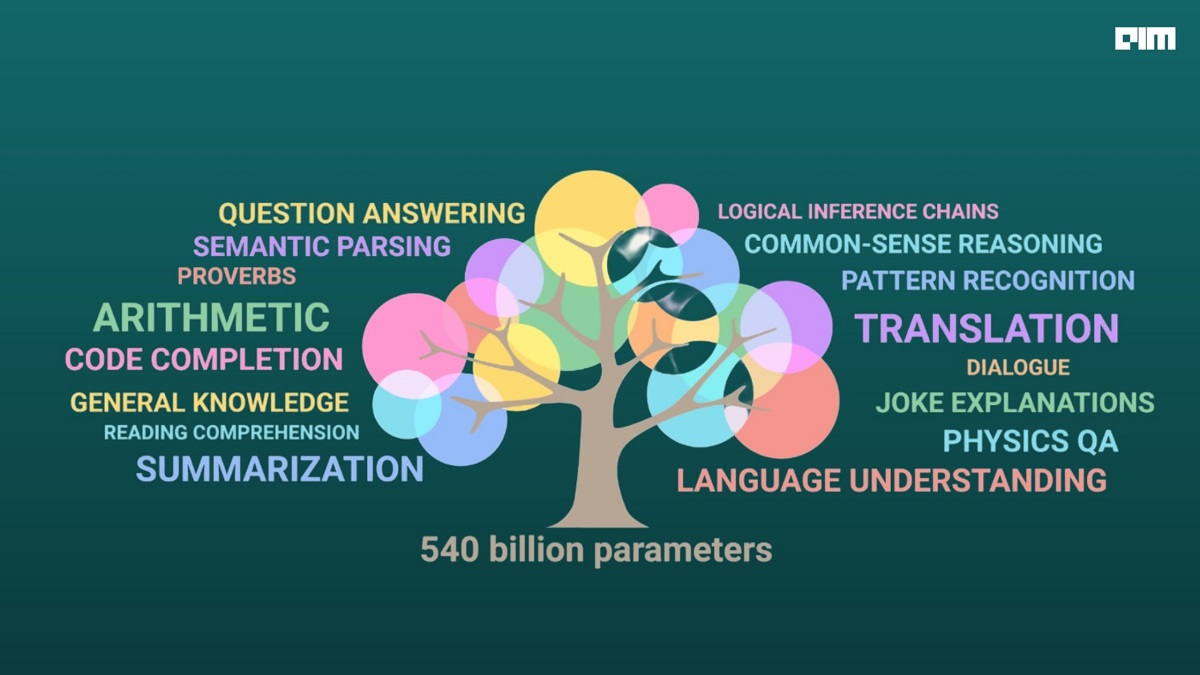

PaLM puede ampliarse hasta 540.000 millones de parámetros, lo que significa que el rendimiento de las tareas aumenta a medida que aumenta la escala del modelo, lo que abre nuevas posibilidades. En comparación, GPT-3 sólo tiene unos 175.000 millones de parámetros.

Puede leer también | GPT el modelo de generación de contenidos basado en la Inteligencia Artificial

El modelo lingüístico de Google está entrenado con el sistema Pathways, que le permite generalizar tareas en una gran variedad de dominios y tareas, además de ser muy eficiente. Pathways es una arquitectura de IA diseñada para producir sistemas inteligentes de propósito general que puedan realizar tareas en distintos dominios de forma eficiente y construir modelos que se "activen escasamente" en lugar de activar toda la red neuronal tanto para tareas sencillas como complicadas. Además, el sistema también está entrenado para procesar múltiples modalidades de información, como texto, imágenes o habla, todo a la vez.

Pathways permite escalar un modelo en decenas de miles de chips TPU (Tensor Processing Unit) de Google. Además, PaLM superó el rendimiento de modelos anteriores de gran tamaño, como GPT-3 y Chinchilla, en 28 de 29 tareas de PLN, superando a la mayoría de las pruebas de referencia de última generación y al ser humano medio.

Como BERT, como PaLM

Sterling Crispin, ingeniero de software y diseñador de producto de XR, comenta que, aunque se habla mucho de que no hay foso en la IA y que lo aplasta todo, hay que tener en cuenta que Google Assistant está en los bolsillos de tres mil millones de personas. Esto convierte a sus centros de datos TPU en el foso. Como resultado, Google será capaz de producir resultados mucho mejores utilizando las toneladas de datos que tienen a su disposición.

Puede leer también | ¿Puede la Inteligencia Artificial crear una película?

Crispin también añade que, aunque seguirá habiendo demostraciones tecnológicas llamativas, como GPT-3 y ChatGPT, en empresas como Google, Meta y Apple ocurren muchas cosas entre bastidores de las que la gente no necesariamente se entera.

Tomemos, por ejemplo, el modelo de transformador, BERT, desarrollado por Google, que actualmente impulsa su búsqueda. Fue una integración importante para la búsqueda, ya que les permitió migrar de resultados basados en palabras clave a resultados basados en el contexto. Un ejemplo sería que antes, para la consulta "estrategias para estudiar bien", producía resultados basados en palabras clave como 'estrategias' y 'estudiar', mientras que, con BERT, la búsqueda de Google entendía contextos como 'para' para producir resultados. De este modo, Google lleva años empleando BERT miles de millones de veces al día.

El BERT de Google también ayuda a agrupar varios artículos de noticias relacionados en carruseles para ayudar a los usuarios a encontrar los mejores artículos relacionados con una noticia concreta. El modelo también se utiliza para mejorar la comprensión de cuándo un buscador está buscando contenido explícito, reduciendo así los "resultados impactantes inesperados" para los buscadores en un 30% en el último año, según Google.

Puede leer también | Presentan superordenador optimizado para la inteligencia artificial puede realizar un quintillón de cálculos por segundo

Así pues, aunque invisible para los usuarios, BERT está en todas partes. Pero no es el único. Google también utiliza Language Model for Dialog Applications (LaMDA), un chatbot conversacional, más recientemente para Google Chat, donde resume una conversación en curso en la ventana de chat.

Google open-sourced BERT en 2018, que ahora ha demostrado ser un cambio de juego. El modelo BERT puede extraer información de grandes cantidades de datos no estructurados y se puede aplicar para crear interfaces de búsqueda para cualquier biblioteca. Google ha aplicado una estrategia similar para PaLM, que también es de código abierto y está disponible públicamente.

Recientemente, Phil Wang (lucidrains) en Github también implementó un marco que permite entrenar PaLM utilizando la misma estrategia de aprendizaje por refuerzo que ChatGPT. Básicamente, al ser de código abierto, algunos ya han transformado PaLM en un ChatGPT más capaz.

Puede leer también | La Inteligencia Artificial revela cómo podrían lucir las Kardashian sin cirugía plástica

Las capacidades de PaLM ya pueden apreciarse en el nuevo producto de Google, Med-PaLM, desarrollado a partir de PaLM y su variante Flan-PaLM ajustada a las instrucciones, para evaluar LLM utilizando MultiMedQA, un modelo de código abierto que proporciona conjuntos de datos para preguntas de opción múltiple y para respuestas más largas a preguntas planteadas por profesionales y no profesionales de la medicina. El resultado, determinado por un grupo de médicos, mostró que el 92,6% de las respuestas de Med-PaLM estaban a la par con las respuestas generadas por los médicos (92,9%). Se trata de una mejora notable, sobre todo si se compara con las respuestas de Flan-PaLM, que se consideraron conformes al acuerdo científico en un 61,9%.

Al igual que con BERT, podemos esperar que Google le dé la vuelta a un sistema como PaLM, modelando una variedad de sus productos.

Google lidera el juego de la IA

La búsqueda en Google representa el 57% del negocio de Google. Así que, independientemente de si uno está del lado de creer que GPT perturbará la búsqueda o de creer que el riesgo era exagerado, es importante considerar que, actualmente, Google tiene un arsenal que es más grande y mejor para hacer frente al desafío. Se puede argumentar aquí que la GPT-4 está al caer, pero no hay información oficial sobre lo que supondrá. Por supuesto, en Internet se han lanzado especulaciones absurdas y generalizadas -los usuarios sospechan que tendrá entre 1 billón y 100 billones de parámetros-, pero eso no dice nada sobre el rendimiento del modelo en sí.

Puede leer también | El generador de imágenes en Inteligencia Artificial Discord bot predice la última selfie jamás tomada

Por otra parte, un reto importante de los LLM que OpenAI tendrá que abordar es cómo reentrenar los modelos para mantener fresco el contenido. Por ejemplo, un modelo como ChatGPT está preentrenado con datos que datan de 2021, y si OpenAI tuviera que actualizar constantemente el modelo con contenido nuevo, resultaría muy caro. En este caso, Google sale ganando frente a OpenAI, ya que limpia continuamente su corpus web, raspando y evaluando páginas para detectar nuevas consultas.